AI che copia non muore mai di fame

Parafrasando un motto poco lusinghiero - solitamente rivolto verso i giornalisti – si potrebbe dire: “AI che copia non muore mai di fame”. Ora, se è pur vero che gli algoritmi si nutrono di dati e di questi nella nostra epoca non ne mancano mai, anzi sono in continua crescita, è altrettanto vero che il moto generativo dei cosiddetti Large Language Model – LLM come ChatGpt o Bard di Google – è completamente basato sull’imitazione. Non essendoci una vera intelligenza dietro, non può esserci creazione originale. Bensì un’elaborazione che si basa su milioni di parametri differenti, su quantità enormi di testo non etichettato – anonimo si potrebbe dire – e in regime di cosiddetto “self-supervised training”. La macchina, o meglio il software basato su reti neurali artificiali, digerisce una mole costante di dati e senza bisogno di intervento umano, regola la propria creazione, raffinandola proprio grazie a questo costante allenamento.

I risultati sono altalenanti, come ben sa chi ha avuto modo di sperimentare le due piattaforme di cui sopra, capaci ogni mese di vedere al lavoro diverse decine di milioni di utenti sparsi in diverse parti del mondo. Più la si usa, l’intelligenza artificiale generativa, e più questa migliora i propri risultati, ribadiamo non originali. Di originale invece spesso c’è la base su cui il software lavora, libri digitalizzati, ricette da portali di cucina, articoli giornalistici. Come quelli del New York Times, per capirci. Che infatti ha minacciato di fare causa a OpenAI, la casa madre di ChatGpt, nel caso perseverasse a mettere nel piatto del proprio software contenuti coperti da diritto d’autore senza pagare il diritto stesso. Il tema non è banale, fa parte di quel pacchetto di rischi contenuto nella diffusione senza controllo di piattaforme AI sostenuto tra gli altri dalla stessa Unesco.

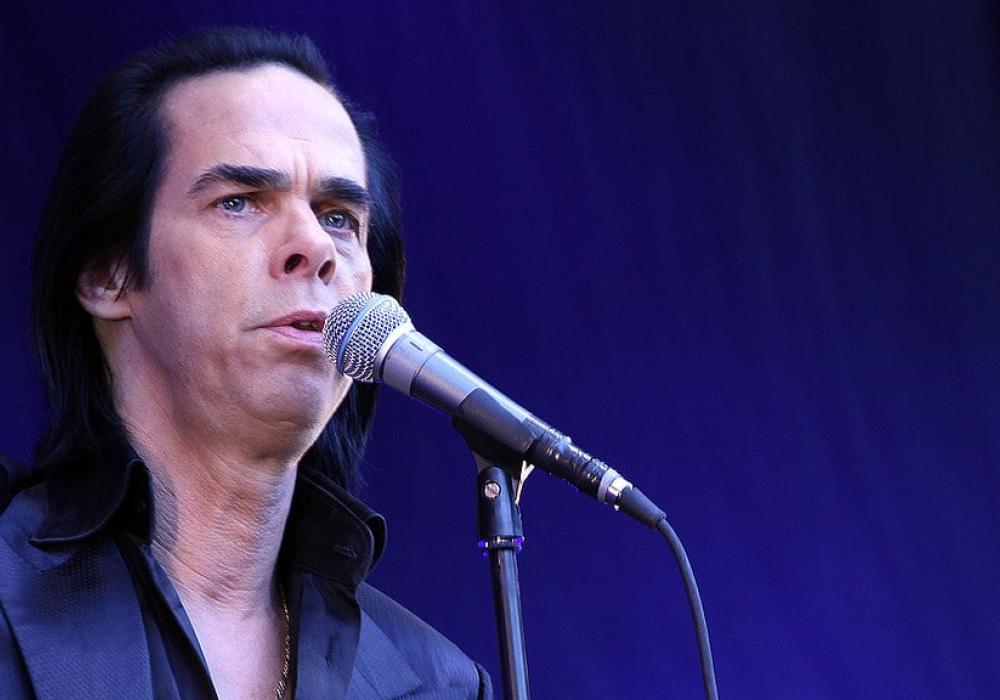

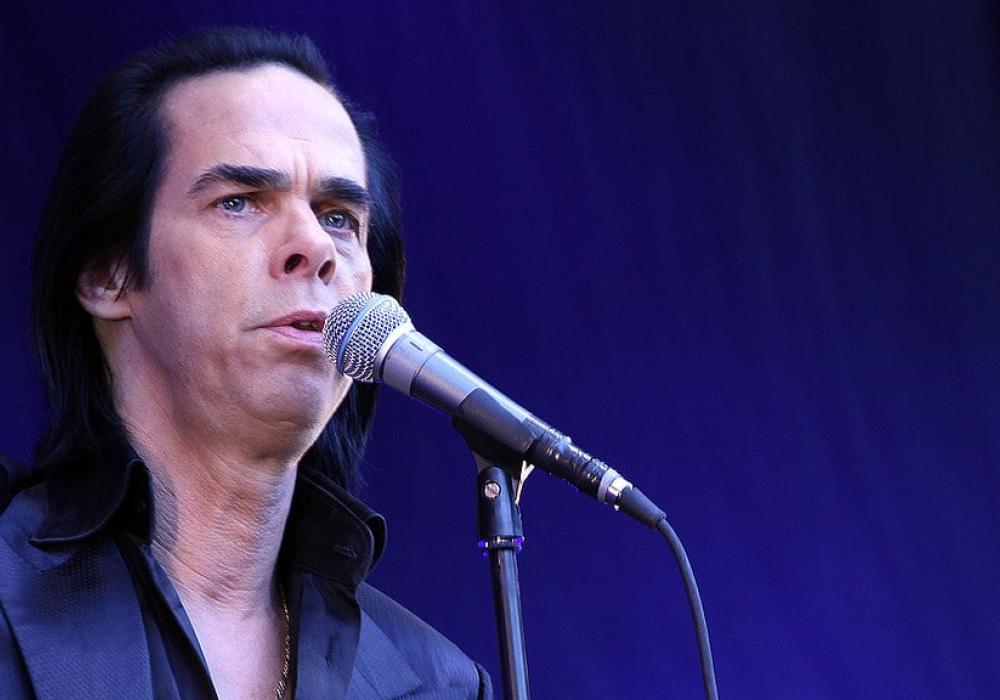

Tra questi, l’appiattimento delle opinioni – se delegate ai suggerimenti di un software “intelligente” – ma anche dei contenuti stessi, quando generati da un sistema che per sua stessa natura non è in grado di elaborare vera originalità. Il tema è estremamente interessante, specie alla vigilia di un’introduzione di questi strumenti nelle scuole a livello globale. L’argomento è trattato appunto dall’agenzia Onu per l’educazione nel suo nuovo studio “Guidance for generative AI in education and research”. Ma per capire ancora meglio quanto è in discussione, pur meno “scientifica” colpisce la spiegazione data da un cantante dalle radici culturali profonde come l’australiano Nick Cave. Il quale, sollecitato da una fan che aveva generato con l‘AI una canzone “in stile Nick Cave”, dopo aver bocciato l’esperimento con un secco “Fa schifo”, successivamente ha spiegato il suo giudizio. “ChatGPT è una copia come parodia. Può essere capace di scrivere un discorso o un saggio, un sermone o un necrologio, ma non può creare una canzone genuina. Forse nel tempo potrà creare una canzone che, superficialmente, non è distinguibile da una originale ma sarà sempre una copia, una sorta di caricatura”. Il motivo? Ecco la spiegazione: “Le canzoni nascono dalla sofferenza, e con ciò voglio dire che si basano sulla umana e complessa lotta interna della creazione e, per quel che ne so, gli algoritmi non sono in grado di sentire. I dati non soffrono. ChatGPT non ha un essere interiore, non è stata da nessuna parte, non ha sopportato nulla, non ha avuto l'audacia di superare i propri limiti e per questo non ha la capacità di una condivisa esperienza trascendente dato che non ha limiti da cui trascendere. Il ruolo malinconico di ChatGPT è che è destinata ad imitare e non può mai avere un'autentica esperienza umana, a prescindere da quanto svalutata e incoerente possa diventare nel tempo l'esperienza umana”.